Es gibt unzählige Suchmaschinen, die unterschiedlichste Aufgaben erfüllen. Von Billigflieger-Vergleichen bis zu Domain-Suchmaschinen besitzen alle besondere Eigenschaften. Dabei ist vor allem die Datenbasis entscheidend für die Qualität der Suchmaschine.

Eine spezielle Suchmaschine, die beispielsweise nur nach günstigen Autovermietungen sucht, muss die Aufgabe erfüllen, sämtliche Anbieter in diesem Bereich aktuell in seinem Datenbestand bereitzuhalten. Zudem muss der Datenbestand strukturiert und sortiert vorliegen, wie in diesem Fall zum Beispiel die Felder „Anbieter“, „Preis“ und „Autoklasse“.

Derartige Suchmaschinen sind in den meisten Fällen frei zugänglich. Daneben gibt es Datenbanken, die aufgrund ihrer wertvollen Datenbasis und hochentwickelten Funktionalitäten Gebühren verlangen. Eine Suchmaschine, die zum Beispiel private Versicherungen mit all ihren Leistungen und Beiträgen auflistet, ist für professionelle Versicherungsmakler von hoher Bedeutung und verlangt dementsprechend Lizenzkosten. Und auch im Bereich Social Media gibt es spezielle Datenbanken und Suchmaschinen, die nicht öffentlich zugänglich sind, wie beispielsweise die sogenannten Deep Crawler.

Deep Web

Kostenpflichtige Online-Datenbanken befinden sich in dem Bereich des Internets, der als „Deep Web“ oder „Invisible Web“ bezeichnet wird. Man nimmt an, dass die Datenmenge im sogenannten Deep Web um mehr als 500-mal höher ist als das freie Internet (auch „Surface Web“ genannt).

Es ist allgemein bekannt, dass hochqualitative Informationen, seien es Kreditauskünfte oder Artikel in wissenschaftlichen Datenbanken, nicht über öffentliche Suchmaschinen auffindbar sind.

Ein relativ junges Feld für Suchmaschinen ist die Erfassung des Deep Web – also Bereiche, die für normale Suchmaschinen nicht erreichbar sind und somit dort auch nicht aufgefunden werden. Doch auch hier gibt es bereits zahlreiche Suchtechnologien, die öffentlich verfügbar sind. Ob nun Twitter- oder Blogsuchmaschinen – diese Dienste ermöglichen das Auffinden von nicht zugänglichen Inhalten. Die Vollständigkeit und Qualität dieser Treffer reichen in den meisten Fällen für Unternehmen und professionelle Einsatzgebiete jedoch nicht aus.

Daher gibt es Anbieter in der Branche des Social Media Monitoring, die eigenentwickelte Suchtechnologien für das Social Web kostenpflichtig anbieten. Diese können besondere Anforderungen erfüllen und sind für Unternehmen von großem Nutzen, da sie nicht nur eine qualitativ hochwertige Datenbank bereitstellen, sondern auch zahlreiche weitere Funktionalitäten bieten. Diese können dann auch individuell auf das Unternehmen zugeschnitten werden.

Deep Web Crawler

Der Markt für Social Media Monitoring in Deutschland wird derzeit von mehreren Anbietern dominiert.

Diese Unternehmen bieten vor allem die Dienstleistung des „klassischen“ Social Media Monitoring bzw. Social Listening an. Der weitere, besondere Fokus solcher Unternehmen liegt im Einsatz von selbstentwickelten Suchtechnologien.

Datenstruktur

Die Datenstruktur solcher Technologien wird oft als Alleinstellungsmerkmal in der Branche angesehen.

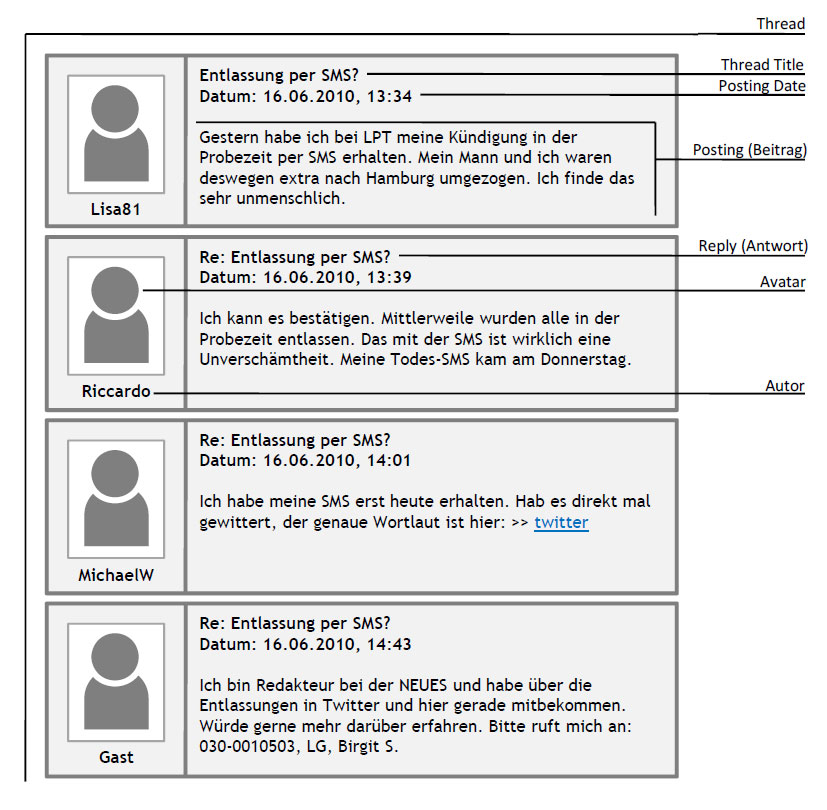

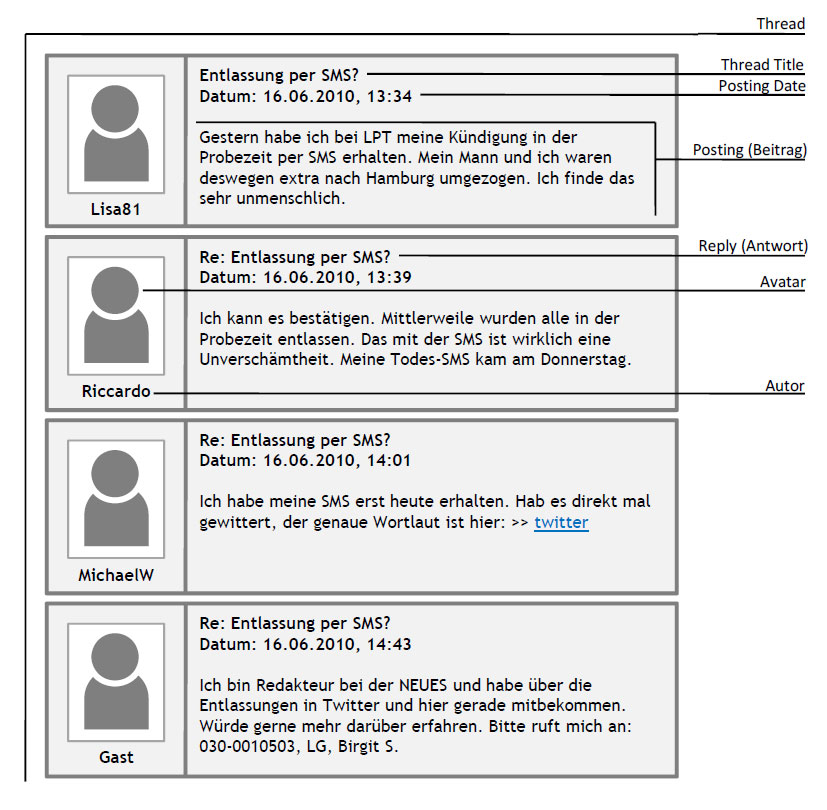

Denn sie hält nicht nur User Generated Content, also von Nutzern oder Konsumenten generierte Inhalte, bereit. Die Daten liegen vor allem in einer besonderen und speziell für die Ansprüche eines professionellen Social Media Monitorings entwickelten Struktur vor. Die Suchmaschine ist in der Lage, unter anderem den Autorennamen, das Datum und die Uhrzeit der Beiträge automatisch zu erkennen. Zudem nimmt sie eine automatische Zuordnung der Beiträge zu Threads und Themenbereichen vor. Diese besonderen Eigenschaften ermöglichen Funktionalitäten, die weit über den Funktionsumfang öffentlicher Suchmaschinen hinausgehen.

Der Vorteil von derart komplexen Suchalgorithmen liegt in der sehr geringen Redundanz. Eine durchdachte Suchanfrage ist in der Lage, aus Millionen von Daten die jeweils relevanten Treffer herauszufiltern. Der Nutzer muss sich dann nicht mehr durch hunderte oder tausende von Treffern kämpfen, sondern erhält Ergebnisse, die zu fast 100% seinem Suchwunsch entsprechen.

Die Tatsache, dass öffentliche Suchmaschinen derart verschachtelte Abfragen (sogenannte „Search Strings“) nicht anbieten, liegt in der hohen, benötigten Rechenleistung begründet. Komplexe Suchalgorithmen können in der Regel nur von kleineren Benutzergruppen mit bis zu maximal 100 Nutzern gleichzeitig gestellt werden. Öffentliche Suchmaschinen wie Google müssen dagegen Millionen Anfragen gleichzeitig bearbeiten und können daher solch komplexe Anfragen nicht zulassen, da ansonsten die Datenbank zusammenbrechen würde. Zumal die Datenstruktur dieser Anbieter auch nicht dem Social Web und den Ansprüchen der Marktforschung gerecht wird. Spezielle Suchmaschinen sind hingegen in der Lage, ihren Nutzern eine eigene Datenbank mit eigenen Servern zur Verfügung zu stellen. Damit haben Suchende die Möglichkeit, sich ohne Performance-Einbußen auf einer Art eigener Spielwiese zu bewegen.

Web Researcher

Zwar kann bei solchen speziellen Suchmaschinen auch der Suchende eigene Suchen eingeben und so die Suchmaschine nutzen, doch bei komplexen Anfragen ist der Einsatz von Spezialisten notwendig.

Wenn es darum geht, spezielle Themen treffergenau aufzulisten (zum Beispiel nur Treffer zu bestimmten Produkten anzuzeigen) sollten ausgebildete Information Researcher zum Einsatz kommen. Diese können dann komplexe Search Strings formulieren und in speziellen vorgesehenen Dashboards der Software speichern. Sucht dann jemand nach seinen Themen oder Produkten, muss er schließlich nur noch die gespeicherten Suchanfragen starten, ohne selbst die Sprache der komplexen Suchalgorithmen erlernen zu müssen. Diese Art der Abwicklung ist im Deep Web im Grunde nicht ungewöhnlich. Viele Unternehmen greifen vor allem in der Marktforschung indirekt auf professionelle Information Broker zurück.

Zeiteingrenzung

Zusätzlich zu der Eingabe von Keywords bieten spezielle Suchmaschinen die Eingrenzung nach Datum.

Auch hierbei sind im Vergleich die öffentlichen Suchmaschinen deutlich unterlegen, da sie derartige Abfragen nicht erlauben. Zwar kann man auch bei manchen öffentlichen Suchmaschinen einen Zeitraum eingeben, jedoch bezieht dieser sich auf den Zugriff durch die Suchmaschinen selbst. Wenn also ein Beitrag am 01.06. geschrieben wurde, die Suchmaschine diesen Beitrag jedoch erst am 12.06. erfasst hat, wird der 12.06. als Datum wahrgenommen. Grundlage für die Erkennung, wann ein Beitrag von einem Autor verfasst wurde, sind spezielle Entitäten mit Bezug auf Social Media und Marktforschung. Vor allem diesen Bereich haben die spezialisierten Social-Media-Monitoring-Dienstleister zu ihrem Fachgebiet erklärt und können mit speziellen Suchmaschinen die hohen Ansprüche von Unternehmen erfüllen.

Der Unterschied zwischen Posting und Thread

Der Vorteil von derart komplexen Suchalgorithmen liegt in der sehr geringen Redundanz. Eine durchdachte Suchanfrage ist in der Lage, aus Millionen von Daten die jeweils relevanten Treffer herauszufiltern. Der Nutzer muss sich dann nicht mehr durch hunderte oder tausende von Treffern kämpfen, sondern erhält Ergebnisse, die zu fast 100% seinem Suchwunsch entsprechen.

Die Tatsache, dass öffentliche Suchmaschinen derart verschachtelte Abfragen (sogenannte „Search Strings“) nicht anbieten, liegt in der hohen, benötigten Rechenleistung begründet. Komplexe Suchalgorithmen können in der Regel nur von kleineren Benutzergruppen mit bis zu maximal 100 Nutzern gleichzeitig gestellt werden. Öffentliche Suchmaschinen wie Google müssen dagegen Millionen Anfragen gleichzeitig bearbeiten und können daher solch komplexe Anfragen nicht zulassen, da ansonsten die Datenbank zusammenbrechen würde. Zumal die Datenstruktur dieser Anbieter auch nicht dem Social Web und den Ansprüchen der Marktforschung gerecht wird. Spezielle Suchmaschinen sind hingegen in der Lage, ihren Nutzern eine eigene Datenbank mit eigenen Servern zur Verfügung zu stellen. Damit haben Suchende die Möglichkeit, sich ohne Performance-Einbußen auf einer Art eigener Spielwiese zu bewegen.

Thread und Postings erkennen

Bereits ein einziges Posting durch einen Autor kann zu einer regen Diskussion in einem Forum führen, in der hunderte von verschiedenen Autoren Antworten und Meinungen veröffentlichen.

Größere Threads haben meist über hundert, manche sogar mehrere tausend Postings vorzuweisen. Solche Threads können sich über Wochen, Monate und sogar Jahre hinweg entwickeln und eine sehr hohe Reichweite erhalten.

Eine der größten Herausforderungen bei der Erfassung von Internet-Foren stellt allerdings die Zuordnung von Threads und Postings dar. Während ein Posting, wenn auch mit einem hohen technischen Aufwand, durchaus nach Datum, Autor und Inhalt sortiert in einer Datenbank erfasst werden kann, scheitern selbst viele professionelle Social-Media-Suchmaschinen, wenn sie versuchen, Postings ihren jeweiligen Threads zuzuordnen.

Spezielle Suchmaschine hingegen erfüllt diese Ansprüche und sind in der Lage, jedes Posting einem Thread zuzuordnen. Diese Funktion hat eine wichtige Bedeutung beim Information Retrieval im Social Web, vor allem wenn es darum geht, hochfrequentierte Themen mit einem Klick zu identifizieren.

Trend Finder

Sobald die Zuordnung von Threads und Postings gewährleistet ist, lassen sich in einem speziellen Trend-Search-Modul kennzahlenbasierte Abfragen realisieren. In einem breiten Themengebiet kann man mit derartigen Modulen eine Auswahl von Themen finden, die über ein hohes Diskussionsvolumen verfügen.

Dieser Abfrage liegt die Annahme zugrunde, dass hochfrequentierte Threads mit vielen Antworten auf wichtige Trends und Entwicklungen in der Internet-Community hinweisen. Diese Annahme ist eine Schlussfolgerung weitgehender, empirischer Beobachtungen aus der Informationswissenschaft: Sobald ein Thema eine große Anzahl von Autoren motiviert hat zu antworten, kann davon ausgegangen werden, dass es sich hierbei um ein für die Nutzer interessantes Thema handelt.

Allerdings reicht die Menge der Autoren als Kennzahl alleine nicht aus. Berücksichtigt werden muss auch die Zeitspanne, in der die Autoren eine bestimmte Menge an Postings publiziert haben. Zudem kommt hinzu, dass es sich um eine heterogene Gruppe von Autoren handeln muss. Es nützt wenig, wenn Suchtreffer in die Ergebnisliste einfließen, in der lediglich zwei Autoren in einer Art „Privatgespräch“ für eine Menge Postings gesorgt haben.

Bei der Trendsuche werden somit drei Schlüsselfelder kombiniert: die Mindestanzahl von Postings, von Autoren sowie der Zeitraum. Durch die Auswahl dieser drei Kriterien können zum Beispiel Abfragen wie diese durchgeführt werden: Aus einer Fülle von 16 Millionen Postings sucht man sich Threads mit mindestens 100 Postings und der Beteiligung von mindestens 40 Autoren aus, die Inhalte innerhalb von 14 Tagen generiert haben. Wenn man diese dann mit Keywords bestückt erhält man eine Handvoll Threads, die absolut relevante Trendthemen darstellen und in kurzer Zeit gelesen und bewertet werden können. Mit solch einer Abfrage hätte ein Unternehmen in wenigen Minuten die wichtigsten Trends in seinem Themenbereich in Social Media abgedeckt.

Auch in diesem Fall ist der Einsatz von professionellen Information Researchern unabdingbar. Über die gespeicherten, vorformulierten Suchabfragen kann man über das Dashboard die Technologie auch ohne Suchmaschinen-Fachwissen effizient nutzen.

Weitere Module in Suchmaschinen

Ist die Datenstruktur anspruchs- und branchengerecht gestaltet, sind Abfragemöglichkeiten in nahezu unendlich verschiedenen Varianten möglich. Die Suche nach den aktivsten Autoren, auch in Kombination mit Keywords, kann beispielsweise mit wenigen Klicks die Opinion Leader oder Heavy User in einem bestimmten Produkt- oder Themenbereich aufzeigen.

Zudem kann die Datenbank auch mit weiteren Inhalten angereichert werden. Eine automatisierte Sentiment-Analyse kann beispielsweise entweder in der kompletten Datenbank oder nur auf einen gefilterten Teilbereich (Data Mart) angewandt werden.

Ebenso können intellektuelle Auswertungen durch Researcher zum Einsatz kommen. Das bedeutet, dass Beiträge durch Researcher (oder durch die Unternehmen selber) gelesen und bewertet werden, um sie später grafisch auszuwerten. Das Prinzip ist bereits von Hotlines und CRMS bekannt.

Fazit

Je spezieller eine Suchmaschine, desto höher die Ansprüche der Branche. Einfache, öffentliche Social-Media-Suchmaschinen können zwar Treffer generieren, genügen professionellen Ansprüchen jedoch nicht. Vor allem kennzahlenbasierte Abfragen gehören nicht zum Funktionsumfang öffentlicher Suchmaschinen.

Spezielle Suchmaschinen dagegen können auf Unternehmen zugeschnittene Suchmodule und eigene Server mit einer individuellen Auswahl von Datenquellen anbieten. Diese sind jedoch kostenpflichtig und eine erfolgreiche Nutzung setzt häufig den Einsatz professioneller Experten voraus. Der Vorteil solcher Systeme liegt jedoch auf der Hand: Gesuchte Informationen können gezielt aus einer riesigen Menge an Daten gefiltert werden. Bei komplexen Fragestellungen können geschulte Researcher spezielle Suchanfragen entwickeln, so dass handlungsrelevante Antworten geliefert werden können.

Bezüglich der Qualität der Daten ist das kostenpflichtige Deep Web dem freien Internet also deutlich voraus. Bei professionellen Monitoring-Anbietern sind jedoch nicht nur die eingesetzten Suchtechnologien, sondern auch die dahinterstehenden Prozesse von großer Wichtigkeit. So wird vor allem der inhaltliche Faktor in den Vordergrund gestellt. Nicht selten entwickelten sich die Vorstellungen der Unternehmen an ein Monitoring erst im praktischen Einsatz. Häufig treten auch Themen und Trends zutage, von denen Unternehmen bislang nichts gewusst haben. Und das Denken und Entscheiden kann ohnehin keine Technologie ersetzen. Der inhaltlichen Auswertung und Aufbereitung relevanter Informationen kommt in vielen Projekten daher eine ebenso große Bedeutung zu wie der Technik. Denn auch die die schönsten Charts und Diagramme nutzen wenig, wenn der Suchende mit den Resultaten nichts anzufangen weiß. So hochentwickelt die Technologie schließlich auch sein mag, sollte sie deshalb richtigerweise als Werkzeug zur Prozessoptimierung und Qualitätssicherung genutzt werden, um den gesamten Prozess des Monitorings zu unterstützen.